自分のサイトがGoogleから「立ち入り禁止」だと思われていないか、不安になりますよね。robots.txtは非常にシンプルですが、たった1行のミスでサイト全体が検索結果から消えてしまう破壊力を持っています。

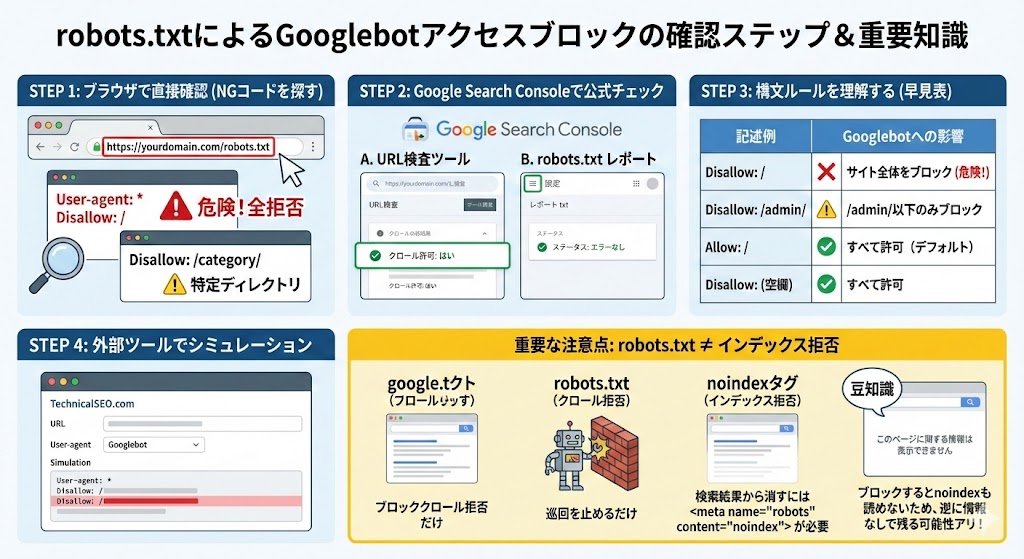

Googlebotのアクセスをブロックしていないか確認するための、確実なステップをまとめました。

1. robots.txtを直接見て「NGコード」を探す

まずは、自分のサイトのrobots.txtの中身をブラウザで開いてみましょう。

URLは通常 https://あなたのドメイン/robots.txt です。

開いたときに、以下の記述がないか探してください。

🚨 最も危険な記述(全拒否)

User-agent: *

Disallow: /

または

User-agent: Googlebot

Disallow: /

この Disallow: / は、「サイト内のすべてのページにアクセスするな」という意味です。これがもしGooglebotに対して設定されていたら、即修正が必要です。

⚠️ 特定のディレクトリを拒否している場合

Disallow: /category/

特定の重要なページがこの「Disallow」の後のパスに含まれていないかチェックしてください。

2. Google Search Consoleで「公式チェック」を行う

一番確実なのは、Googleが提供しているツールを使うことです。

A. 「URL検査」ツールを使う

- Google Search Consoleにログインします。

- 上部の検索窓に、確認したいページのURLを入力します。

- 結果の中に「クロールを許可されていますか?」という項目を探します。

- ここが「はい」になっていればOK。「いいえ:robots.txt によってブロックされました」とあれば、ブロックされています。

B. 「robots.txt レポート」でエラーを確認

Search Consoleのメニューから [設定] > [robots.txt] を開くと、Googleが最後に読み込んだrobots.txtの内容と、エラーが出ていないかを確認できます。

3. robots.txt の構文ルールを正しく理解する

ブロックされているかどうかを判断するために、簡単なルールを整理しておきましょう。

| 記述例 | Googlebotへの影響 |

User-agent: * | すべてのクローラーに適用される指示 |

Disallow: / | サイト全体をブロック(一番危ない!) |

Disallow: /admin/ | /admin/ 以下のページのみブロック |

Allow: / | 基本的にすべて許可(デフォルトなので書かなくてもOK) |

Disallow: (空欄) | 何もブロックしない(=すべて許可) |

4.ちなみに、ワードプレスで自分のrobots.txt を調べてみました。

結果

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://hopa.jp/wp-sitemap.xml

1. User-agent: *

- 意味: 「すべてのロボット(クローラー)に対して指示を出します」

- Googlebotだけでなく、Bingやその他の検索エンジンすべてに共通のルールを適用するという宣言です。

2. Disallow: /wp-admin/

- 意味: 「管理画面(

/wp-admin/)の中は見なくていいですよ」 - WordPressの管理画面は検索結果に出る必要がない(ログインが必要なページばかり)ため、クローラーの無駄な巡回を防ぐために設定されています。

- 注意点: サイトの表側のページ(記事や固定ページ)をブロックするものではないので、SEO上の問題はありません。

3. Allow: /wp-admin/admin-ajax.php

- 意味: 「

/wp-admin/の中はダメと言ったけど、このファイルだけは見てOKです」 - これは非常に重要です。WordPressのテーマやプラグインは、このファイルを使って動的な表示(スライダーやフォームなど)を行うことがあります。Googleがページを正しく「レンダリング(見た目を再現)」するために必要なので、ここだけ例外として許可されています。

4. Sitemap: https://hopa.jp/wp-sitemap.xml

- 意味: 「サイトの地図(サイトマップ)はここにあるので、参考にしてください」

- クローラーに対して、効率よくサイト内のページを見つけるためのヒントを与えています。

結論:この設定は「合格」です!

この内容は、WordPressがデフォルトに近い形で生成する、あるいは多くのSEOプラグインが推奨する設定です。

- Googlebotはあなたの記事を読めますか? → はい、読めます。

- SEOに悪影響はありますか? → いいえ、ありません。むしろ適切です。

[!NOTE] もし特定の記事が検索結果に出てこないなどの悩みがある場合は、

robots.txtではなく、そのページ自体にnoindexタグが設定されていないか、あるいは Search Console で別のエラーが出ていないかを確認するのが次のステップになります

5. 外部のテストツールでシミュレーションする

Search Consoleの設定が終わっていない場合は、外部の「robots.txt チェッカー」を使うのも手です。

- TechnicalSEO.com などのツールに、自分のサイトのURLとユーザーエージェント(Googlebot)を入力すると、どの行が原因でブロックされているかを視覚的に示してくれます。

注意:robots.txt は「インデックス」を拒否するものではない

ここがよくある勘違いなのですが、robots.txtは「クロール(巡回)」を拒否するものであり、「検索結果に表示させない(インデックス拒否)」ためのツールではありません。

もし「検索結果に出したくない」のであれば、robots.txtでブロックするのではなく、ページ側に noindex タグを設置する必要があります。

豆知識:

robots.txtでブロックしてしまうと、Googleはそのページの中身を読めないため、noindexタグが貼ってあることすら気づけず、逆に検索結果に残り続けてしまう(「このページに関する情報は表示できません」という表示で残る)ことがあります。

コメント